xAI、開発LLM「Grok 1.5」発表 近く公開

【東京総合 = テクノロジー】イーロン・マスク氏が立ち上げたAIスタートアップ「xAI」は12日、同社が開発している大規模言語モデル「Grok/」の最新版であるGrok 1.5を開発した。

xAIは、マスク氏や元Google・OpenAIの従業員などが集まって昨年7月に設立した。X上の投稿や画像などをもとに学習を進めている。設立から9ヶ月という短期間で急速に進歩していて、Grok 1.5では推論能力や文脈理解力が大幅に向上。さらに初の画像認識機能も実装され、テキストと画像を組み合わせたマルチモーダルモデルへと進化を遂げた。

一般利用者は、Xの有料プラン「X Premium(旧Twitter Blue)を契約すると利用できる。なお、現時点で英語のみの対応となっており、日本ユーザーは使うことができない。

Grok 1.5の最大の特徴は、高度な推論能力だ。数学や理科のベンチマークテストでは軒並み高得点を叩き出し、数学の問題集「MATH」では50.6%、算数・数学の問題集「GSM8K」では90%、プログラミングの評価指標「HumanEval」でも74.1%を達成した。さらに一部環境では、AnthropicのClaudeの中量級モデル「Sonnet」や、Googleの「Gemini Pro」、OpenAIの「GPT-4 Turbo」 を上回る結果を残したという。

| Benchmark | Grok-1.5 | Claude 3 Sonnet | Gemini Pro | GPT-4 | Claude 3 Opus |

|---|---|---|---|---|---|

| MMLU | 81.3% | 79% | 83.7% | 86.4% | 86.8 |

| MATH | 50.6% | 40.5% | 58.5% | 52.9% | 61% |

| GSM8K | 90% | 92.3% | 91.7% | 92% | 95% |

| HumanEval | 74.1% | 73% | 71.9% | 67% | 84.9% |

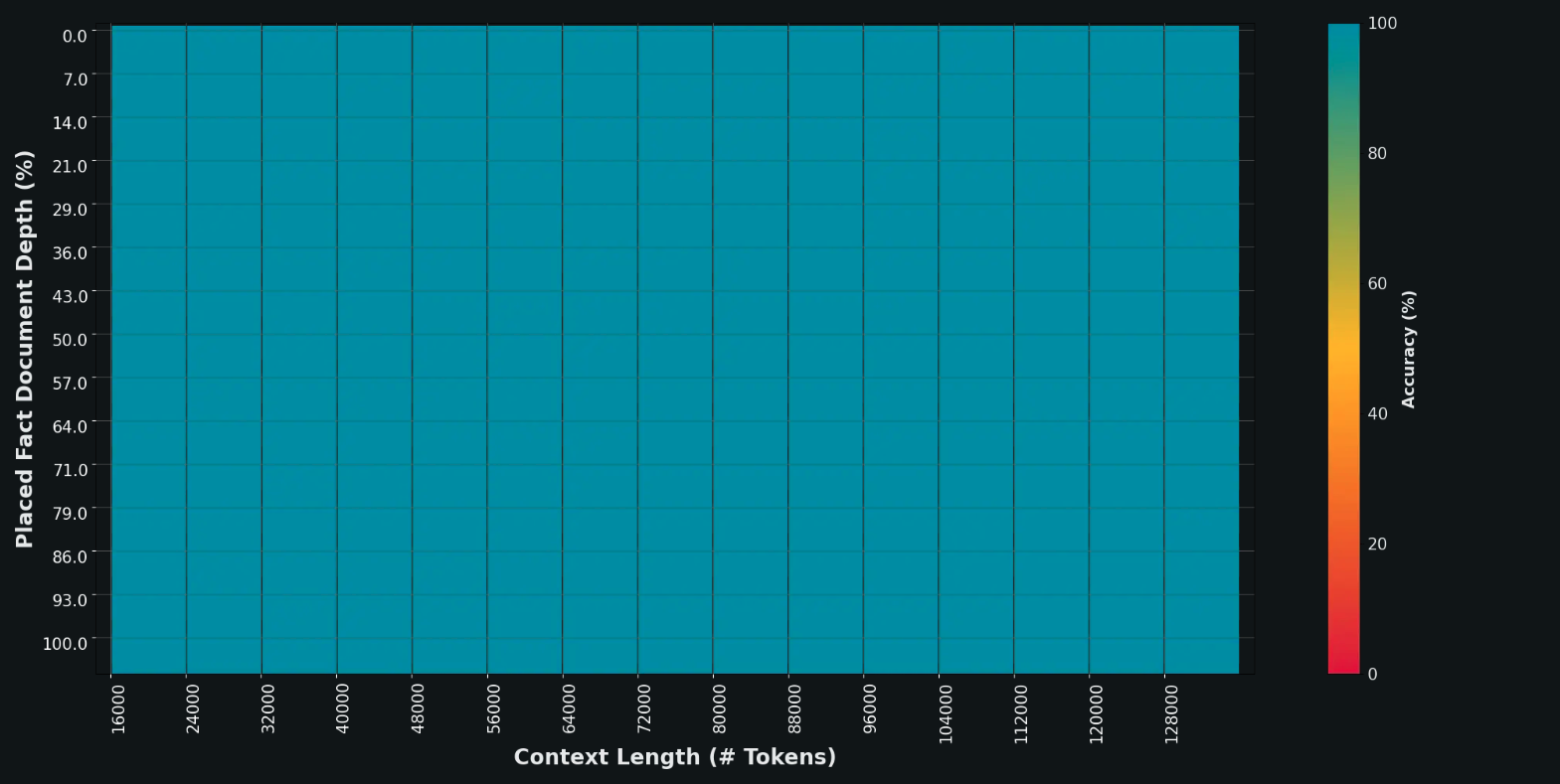

また、Grok 1.5は最大128,000トークンの長い文書を処理できるようになった。前バージョンと比べてメモリ容量を16倍に拡大。はるかに長く複雑な文章を理解することが可能だ。加えて、文脈の範囲が広がってもなお、的確に指示に従う能力を維持している。大量の埋め込みテキストから必要な情報を見つけ出すタスク「NIAH」では、完璧なスコアを収めた。

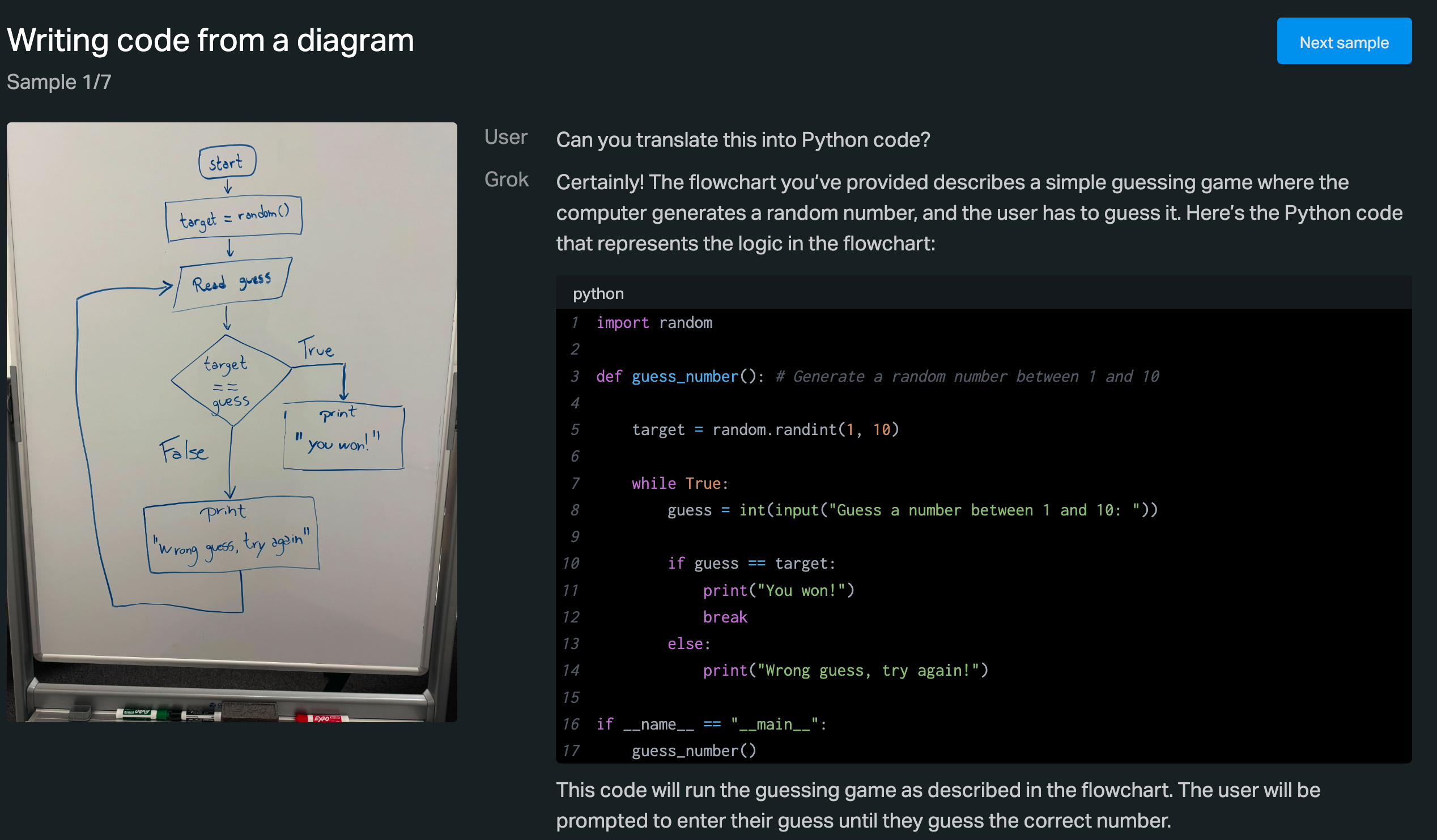

さらに、画像認識機能を備えたGrok 1.5Vでは、資料、図表、スクリーンショット、写真など様々なビジュアル情報を理解できるようになった。競合と比較しても、ほとんどのベンチマークで肩を並べる結果を残している。とりわけ現実世界の空間把握力に秀でており、この分野の新たな指標「RealWorldQA」ではダントツの成績を収めた。例えば、車載カメラの映像から周囲の状況を判断し、安全運転のための意思決定を下すことができる。

プレスリリースにはいくつか例が載せられている。例えば、ホワイトボードに手書きで書いたプログラム構造をもとに、「これをPythonコードに変換してくれない」とユーザーがプロンプトを与える。Grokはそれに基づいてPythonコードを生成した。

コーディングすることも可能になった。

他にも、子供のかいた手書きのイラストをもとに、子守の物語を作ってくれたりした。商品に書かれた栄養表示から、カロリーの計算なども可能だといい、画像認識能力が大幅に向上していることがうかがえる。

Grokの開発チームは、JAX、Rust、Kubernetesをベースにした独自の分散学習フレームワークを構築し、大規模なGPUクラスタ上で最先端のLLM研究を行う。モデルのアーキテクチャを柔軟に変更しながら、効率的に学習を進められる環境が整っているという。今後数ヶ月のうちに、画像、音声、動画などマルチモーダルな理解と生成の能力を飛躍的に高める計画だ。

夏頃には競合のOpenAIがGPT-5を発表することがリークされているほか、現時点で圧倒的な性能を誇るClaude 3 Opusにはベンチマークで敗北している。学習に使うGPUの不足なども取り沙汰されるなど、課題も尽きない。先月にはマスク氏がGrokをオープンソース化を表明するなど、収益モデルにも懸念が残る。